Разработанный сервис позволяет быстро парсить данные с каталогов продукции (интернет-магазинов). Собранные данные можно использовать для наполнения своего сайта или получения информации для анализа. Благодаря нашему опыту и умению строить сложные SaaS решения нам удалось организовать многопоточный парсинг. Архитектура приложения масштабируемая и гибкая для выполнения различных задач. Сбор и анализ информации осуществляется в автоматическом режиме роботом. Для настройки разметки не нужно быть программистом, мы предусмотрели интерфейс, который позволяет вручную разметить данные, которые должен собрать робот.

Для каких целей вы сможете его применить?

Для сбора данных робот-парсер должен знать на какие страницы следует зайти.

Функционал системы предусматривает 2 способа сбора структуры сайта:

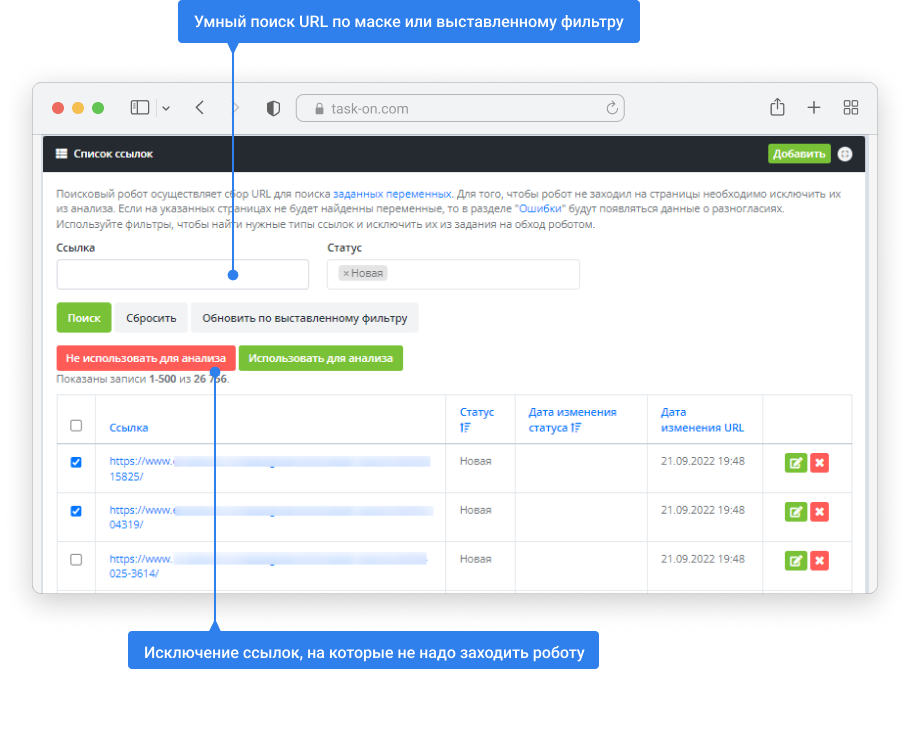

Интерфейс модерации собранных ссылок. В примере ниже робт собрал 26 тыс. страниц, среди которых есть лишние (не требующие анализа). Удобная система фильтрации позволяет быстро найти ненужные ссылки и исключить их из задач робота-парсера. Такая модерация на большом объеме данных позволяет значительно снизить скорость сбора данных.

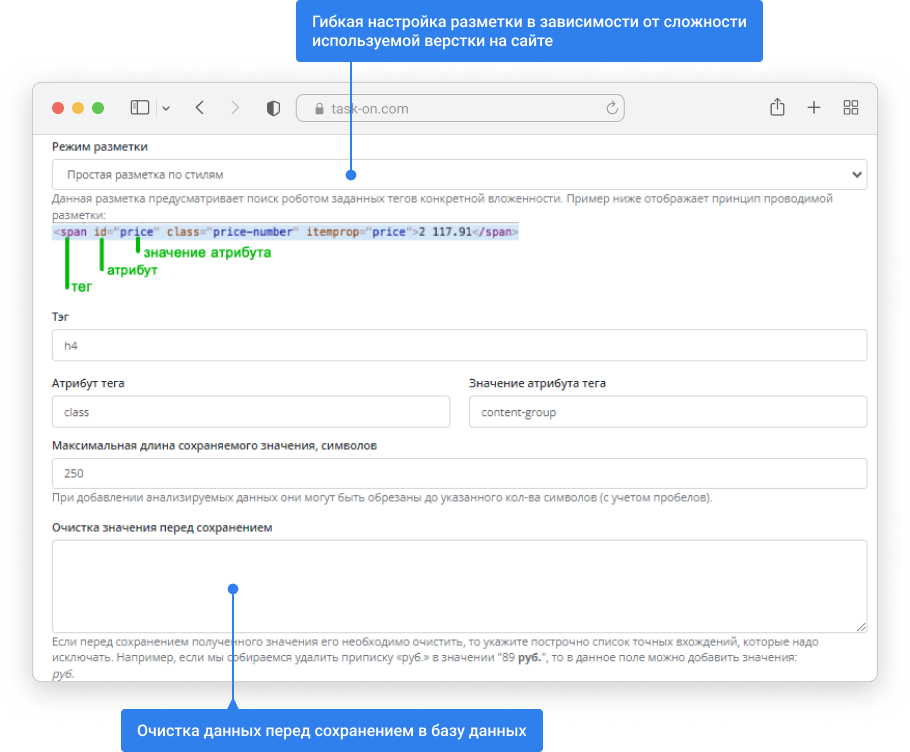

Парсинг данных сильно зависит от верстки анализируемой страницы. Когда верстка меняется, то вместе с ней должна измениться разметка для робота. Если вы анализируете один сайт, то с этой задачей сможет справиться программист. Когда у вас промышленная задача на сбор данных с 50-200 сайтов, то постоянно возникают изменения, которые невозможно оперативно отслеживать и поддерживать.

Мы сделали настройку разметки, которая не требует привлечения программиста. Вы можете разместить данные и их тип через интерфейс приложения. Дальше работу соберет данные. Если измениться верстка, то достаточно будет перенастроить систему и не ждать включение программистов для анализа и решения проблемы.

Наш алгоритм поддерживает сбор данных как со статичных сайтов, так и с асинхронных. Асинхронный сайт, это сайт у которого контент загружается динамически без перезагрузки страницы, например при активации фильтра (такие сайты часто пишут на языке программирования Java Script).

Анализ данных можете провести в двух форматах:

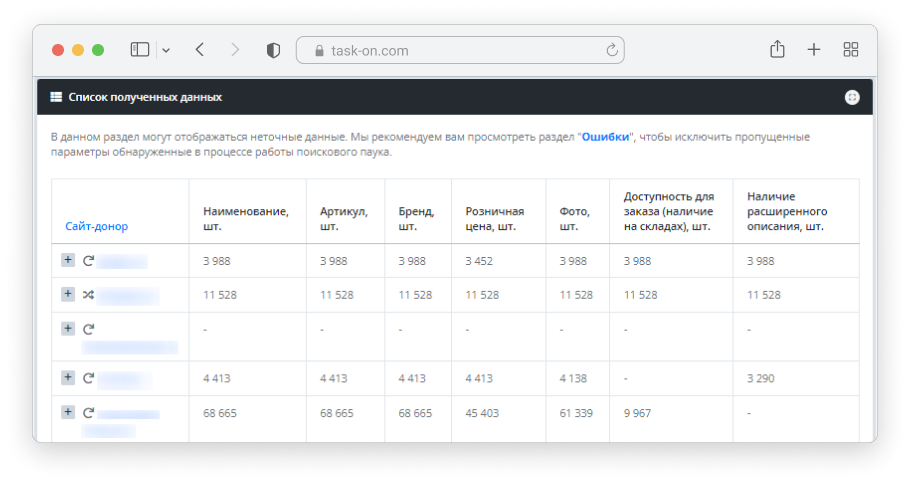

Мы сделали несколько интерфейсов, которые позволяют быстро изучить и при необходимости сравнить полученные данные.

Сервис поддерживает функционал мониторинга цен конкурентов, который позволяет увидеть сравнительный анализ по конкретному товару или группе товаров.

При необходимости данные можно выгрузить в Excel, CSV или XML формат для импорта в другую систему.

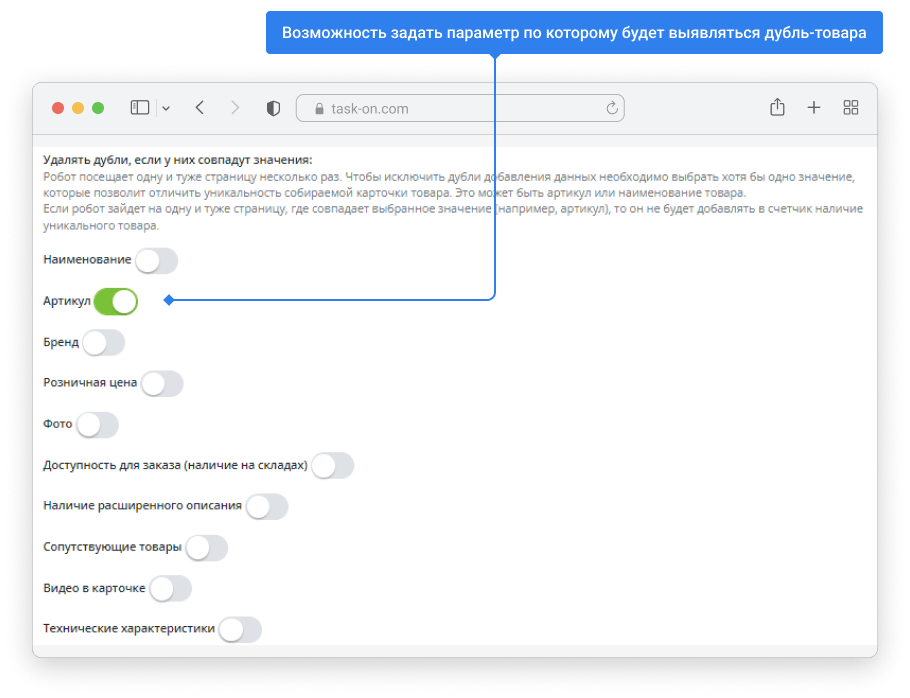

Когда вы собираете большое количество товаров, то могут встречаться дубли. Мы разработали гибкий функционал, который позволяет удалять одинаковые данные, даже если они были на разных URL страницах. Для каждого проекта вы сами настраиваете правила при котором собранные данные будут считаться будем. Например, в примере ниже из карточки интернет-магазина извлекается артикул. Если артикул совпадает, то данные не дублируются, а дополняются.

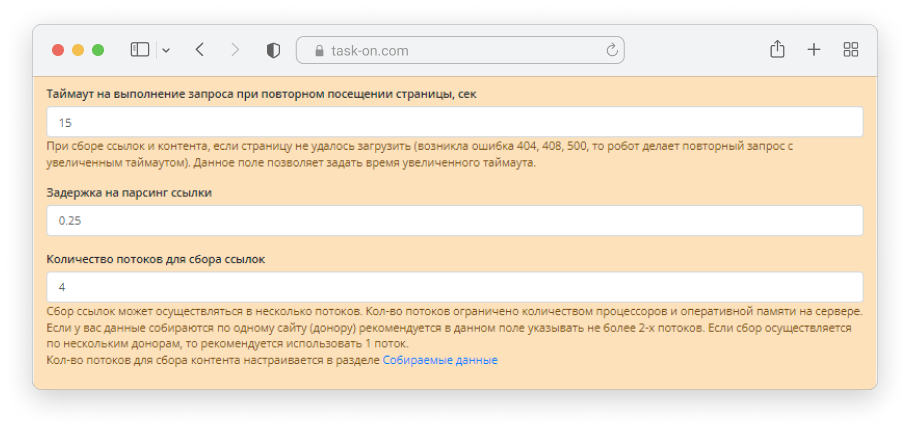

Мы специализируемся на разработке сложных высоконагруженных проектов. Сервис описанный в данном кейсе спроектирован с учетом возможности масштабирования. Мы реализовали многопоточный сбор данных.

За счет большого количества потоков значительно увеличивается скорость сбора данных и появляется возможность сбора одновременно нескольких проектов.

Сервис поддерживает сбор данных как со статических сайтов, так и с асинхронных (контент на которых загружается отдельно от загрузки страницы, например, сайты написанные на Java Script).

Проект размещен на облачной инфраструктуре, что позволяет быстро добавлять кол-во процессоров и объем оперативной памяти для увеличения потока и, соответственно, скорости сбора и анализа данных.

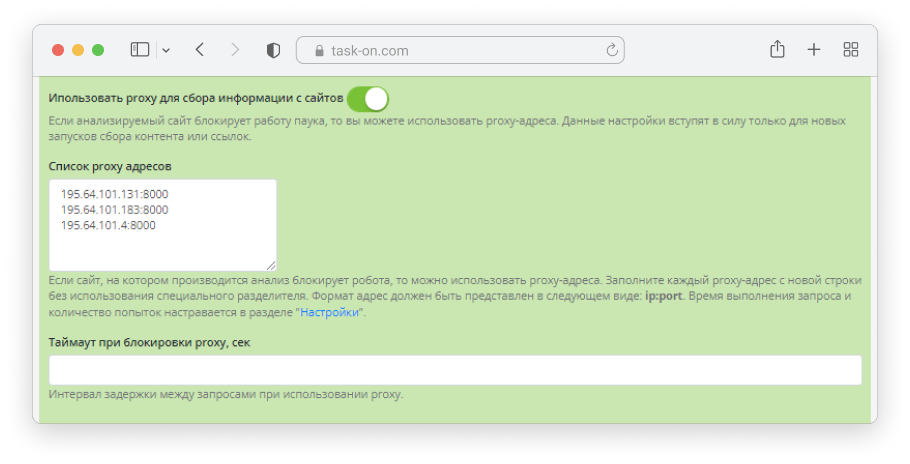

Если вы начнете часто обращаться к анализируемому сайту, то скорее всего он вас заблокирует.

Система имеет массу встроенных функций по обходу блокировки сайтов-доноров. Для каждого анализируемого сайта можно задать таймаут обращения. Система логирования ошибок с подсказками позволяет сориентироваться и подобрать нужный интервал между запросами.

Встроенный функционал позволяет применять proxy-адреса для сбора данных. Proxy - имитирует посещением сайта с разных источников и не позволяет заблокировать робота по ip-адресу.

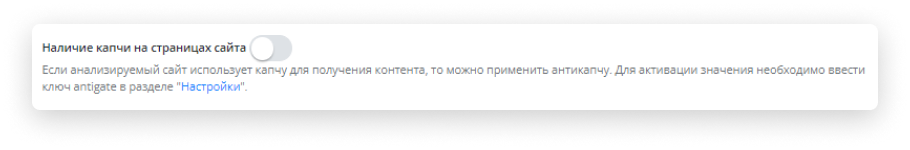

Если анализируемый сайт выводит капчу, то можно задать настройки для автоматического обхода капчи (подключить в несколько кликов сервис анти-капчи).

Для того, чтобы мы смогли Вам предоставить доступ расскажите немного о себе

Опишите в форме ниже задачу, которую требуется реализовать.